Datenschutz

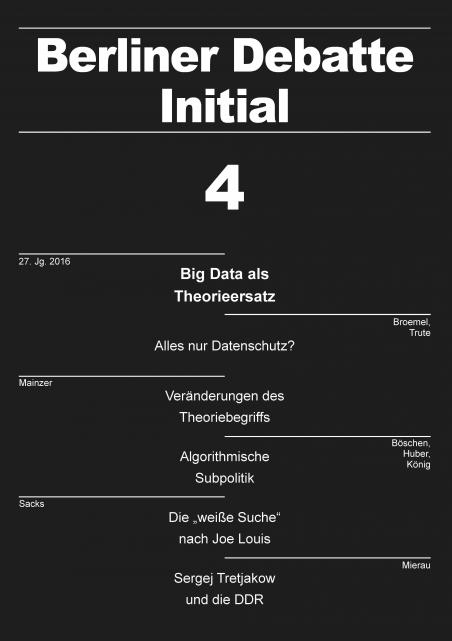

Alles nur Datenschutz?

16 Seiten | Autor: Roland Broemel, Hans-Heinrich Trute

Wissensgenerierung unter Einsatz von Algorithmen ist zwar keine gänzlich neue Praxis, wohl aber eine, deren Bedeutung zunimmt und deren Reichweite erst langsam in den Fokus der rechtswissenschaftlichen Beobachtung rückt. Anders als in den USA, wo es seit Jahren eine lebhafte Debatte um den Einsatz und mögliche Regulierungsnotwendigkeiten von Algorithmen gibt, dominiert in Deutschland der datenschutzrechtliche Aspekt. Damit wird eine inputorientierte Problemperspektive gewählt. Es liegt allerdings auf der Hand, dass zentrale Prämissen des Datenschutzrechts brüchig werden, in einer digitalisierten Welt, in der der Einzelne nicht selten „freiwillig“ und freigiebig Datenspuren hinterlässt. Am Beispiel von Scoring-Technologien (etwa bei der Beurteilung der Kreditwürdigkeit) wird deutlich, dass es oftmals nicht auf personenbezogene Daten (und ihre Kumulation) ankommt. Die anonymisierte Clusterbildung über algorithmisierte Wissensgenerierung kann zur Bildung von Klassifikationen führen, die dem Einzelnen als Wissensbestände einer Risikoeinschätzung gegenübertreten, ohne dass die Betroffenen die Konstitutionsbedingungen übersehen können. Über die Begrenzung des Inputs an personenbezogenen Daten ist dies nicht zu steuern.

PDF: 0,00 €

Big Data als Theorieersatz

ISBN 978-3-945878-11-8 | ISSN 0863-4564 | 146 Seiten

Big Data ist zum Schlagwort für das Sammeln und Auswerten enormer Datensätze geworden, die aus den digitalen Aktivitäten der Menschen gefiltert und von Algorithmen auf Muster hin analysiert werden. Wirtschaft, Politik, Alltagskommunikation, Öffentlichkeit, Kultur und Sport - all das wird von Big Data Schritt für Schritt durchdrungen. Doch was bedeutet Big Data für Wissenschaft und Forschung, vor allem: für die Sozial- und Geisteswissenschaften? Diese Frage steht im Mittelpunkt des aktuellen Themenschwerpunkts. Sie zu stellen, liegt nicht zuletzt deshalb nahe, weil sich mit dem Aufstieg von Big Data eine Provokation verbindet, die direkt auf das Selbstverständnis der Sozial- und Geisteswissenschaften zielt. Auf den Punkt gebracht hat sie der britische Journalist und Unternehmer Chris Anderson vor fast zehn Jahren, als er mit markigen Worten das Ende der Theorie und die Überflüssigkeit wissenschaftlicher Methoden verkündete.

Die sieben Schwerpunkttexte fragen einerseits, was von der steilen These, Big Data trete an die Stelle der Theorie, zu halten ist. Andererseits erkunden sie soziale, rechtliche und politische Implikationen von Big Data und demonstrieren damit, dass sozial- und geisteswissenschaftliche Analysen nicht überflüssig werden, sondern nötig sind, um Big Data zu begreifen. Der Themenschwerpunkt setzt damit eine Diskussion in unserer Zeitschrift fort, die Tara Fenwick und Richard Edwards in ihrem Text über die Auswirkungen digitaler Technologien auf Berufe und Professionen angestoßen haben (siehe HIER). Eröffnet wird der Schwerpunkt mit einer thematischen Einführung, die die einzelnen Aufsätze vorstellt.

Im allgemeinen Teil dieses Heftes laden wir Sie ein, zusammen mit Marcy S. Sacks einen neuen Blick auf die Boxlegende Joe Louis und die zeitgenössische Deutung seiner spektakulären Sporterfolge zu werfen. Fritz Mierau fragt anschließend, welche Rolle der avantgardistische Schriftsteller Sergej Tretjakow, der dem Stalinschen Terror 1937 zum Opfer fiel, im intellektuellen Haushalt der DDR spielte. Danach beleuchtet Loïc Wacquant das Bedeutungsspektrum und Analysepotential des Habitus-Konzepts, das durch die soziologischen Arbeiten Pierre Bourdieus berühmt geworden ist. Cornelia Heintze legt schließlich dar, wie verschiedene Spielarten des Kapitalismus, die Geschlechterfrage und der Stellenwert sozialer Dienste in Europa zusammenhängen.

Inhalt

-

-

-

-

-

Zur rechtlichen Regulierung algorithmenbasierter Wissensgenerierung

-

-

-

-

Die Versuche weißer Amerikaner, Joe Louis für sich zu deuten

-

Sergej Tretjakow im intellektuellen Haushalt der DDR

-

-